‘파수 데이터 레이더’와 ‘랩소디’, 국내외에 적극 영업할 계획

전국 공공기관과 기업 개인정보보호 및 정보보안 실무자 1천여 명이 참석한 PASCON 2019가 지난 10월 29일 양재동 더케이호텔서울 가야금홀에서 성황리에 개최됐다.

이 자리에서 Fasoo(파수닷컴) 김규봉 본부장은 ‘다크 데이터 제어: 차세대 데이터 보안과 데이터 관리’를 주제로 강연을 진행했다. 강연 주요 내용은 다음과 같다.

데이터에 대해서 우리는 두 가지 측면의 목표를 가지고 있다.

보안적으로 보면 리스크, 위험요소를 줄이는 것이고 관리적 측면에서 보면 Productivity, 생산성을 높이기 위한 것이다.

그 동안 우리는 하나의 데이터에 대해 두 가지 측면을 기준으로 다양한 솔루션을 각각의 부서에서 투자해 오고 운영하고 있다.

CISO를 중심으로 하는 정보보안팀에서는 DRM, DLP, APT 탐지, DB암호화 등 많은 솔루션을 적용 및 운영하고 있으며, CIO 중심의 정보기획팀에서는 이메일, 그룹웨어, 메신저, 파일서버, 협업 시스템, 지식관리 시스템 등 다양한 솔루션을 요구사항에 따라 도입 운영하고 있다.

이렇게 많은 솔루션을 시대의 흐름에 맞춰 도입 운영하고 있지만 아직도 우리는 무엇인가 부족하고 새로운 솔루션을 매년 검토하고 있다.

보안팀에서는 계속적인 보안솔루션을 적용함에도 막연한 불안감을 가지고 있다. 언제 보안사고가 터질지 몰라 장기휴가는 꿈도 못 꾼다는 모 보안 담당 임원의 이야기가 이를 잘 증명하지 않을까. 클라우드, 모바일 등 새로운 기술에 따른 보안 이슈가 계속해서 등장한다. 사용자는 다양한 환경에서 편리하게 사용을 원하지만 보안팀 입장에서는 무턱대고 허용하기는 쉽지 않은 상황이다. 이렇게 시대에 따라 다양한 솔루션이 도입되다 보니 보안등급도 시스템에 따라 다르게 운영 되는 것도 현실이다.

또한 데이터 증가에 따라 이를 저장하는 스토리지 또한 매년 늘어만 가고 있다. 많은 데이터가 쌓이다 보니 원하는 정보를 찾기도 어렵고 각 개인이 PC에 보관하고 있던 데이터는 쉽게 사라져 회사의 자산이 되지 못하고 있다. 이를 모두 모은다 하더라도 수 많은 중복 데이터는 더욱 큰 문제가 되고 있는 것도 현재의 문제점이다.

데이터는 계속 늘어만 간다. 한 번도 줄어든 적이 없다.

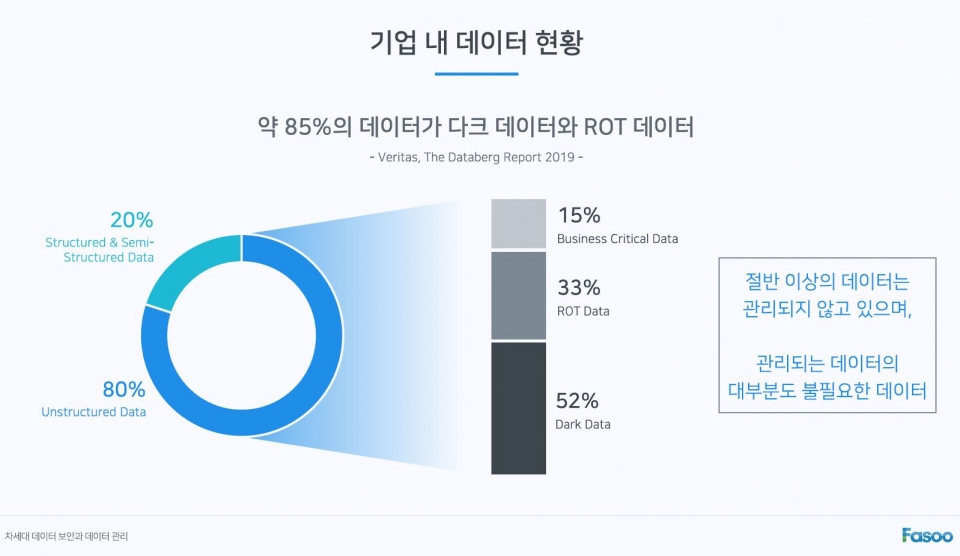

IDC 자료에 의하면 데이터는 매년 80% 이상 증가하고 있고 2017년 이후 이 속도는 계속 증가하고 있다고 한다. 그리고 Veritas의 The Databerg Report에 의하면 데이터의 약 80%가 비정형 데이터 (Unstructured Data)이고 이중 반 이상의 데이터가 다크데이터(Dark Data)이며, 33%는 ROT 데이터라고 분석한다. 단지 15%정도의 데이터만이 업무에 도움이 될 수 있는 데이터라는 이야기다.

어려운 단어들에 대해서는 좀 정리할 필요가 있을 것 같다.

가트너에서는 다크데이터에 대해서 "수비, 처리, 저장 되었지만 활용되지 않는 정보 자산"이라고 정의를 하고 있다. '모르는 데이터'로 표현하는 것이 좀 더 이해가 쉬울 듯 하다. AIIM에서는 ROT 데이터에 대해서 "중복되고, 오래되고, 중요하지 않은(Redundant, Outdated, Trivial) 데이터"라고 이야기를 한다. 아마도 '불필요한 데이터'라고 표현 하는 것이 나을 것 같다.

이제 우리는 '모르는 데이터'는 찾아서 식별분류하고 '불필요한 데이터'는 최소화 하는 것이 새롭고 명확한 데이터에 대한 목표가 될 것 같다.

혹자들은 그 동안 도입했던 솔루션들을 이용해서 분류식별과 불필요한 데이터의 제거 없이도 보안과 관리가 가능하지 않냐는 반론을 하기도 한다.

어느 정도는 가능할 수도 있다. 하지만 대상이 많다는 것은 보안의 허점이 생기기 쉽다는 것을 의미 할 뿐 아니라, AI와 같은 새로운 기술을 적용 할 때도 많은 시행착오와 비용이 든다는 것도 잘 알려진 사실이다. 다시 말해서 식별 분류 후 불필요한 데이터 줄이는 과정이 없다면 위험요소는 높아지고 생산성은 저하되는 상태가 계속 될 수 밖에 없다.

한 번 예를 들어 보도록 하겠다. 내년도 사업계획을 준비할 시기가 되어 올 해 만들었던 사업계획서를 얼마 전 새로 도입한 '통합검색 시스템'에서 찾아 보도록 하겠다. 2019년 사업계획서라는 키워들 넣자 통합검색 시스템은 여러 개의 결과를 보여 준다. 같은 파일명의 문서도 한 대여섯 개가 보이며 비슷한 파일명을 가진 문서도 여러 개 보인다. 이 중 제가 찾고자 했던 사업계획서는 과연 어느 것일까? 그리고 시스템에 따라서 같은 파일명인데도 어떤 파일은 접근조차 할 수 없다. 최종 결과물을 확인하기도 쉽지 않을 뿐더러 내용조차 확인 할 수 없는 상황이 발생하기도 한다.

그런데 왜 이런 불필요한 데이터는 계속 증가 할까.

우리의 업무 일상을 돌아보면 답은 쉽게 찾을 수 있다. 끊임없이 '복사본'을 만들어 내고 있다. 파일을 첨부할 때, 다운로드 받을 때 혹은 첨부가 있는 이메일을 수 많은 사람에게 전달 할 때 등등. 계속해서 문서의 똑같은 복사본을 이곳 저곳에 만들게 된다. 협업을 할 때는 '파생본'이 생긴다. 문서를 만들어 배포 한 후에 수정 사항이 생겨 재배포를 하게 되면 먼저 배포된 문서는 불필요한 문서가 되어 버리고, 협업해서 하나의 문서를 만들기 위해 각자 맡은 부분은 통합본을 만든 후에는 역시 불필요한 문서가 되어 버린다.

그래서 성공적인 데이터 관리와 보안의 필요 조건은 첫째로는 모르는 데이터는 찾아서 식별 분류해야 하고 둘째로 불필요한 데이터에 대해서는 ROT 제거를 통해 최소화 해야 한다. 그리고 나서 중요 데이터에 대해서만 보안이나 관리가 적용이 되어야 성공적인 데이터 관리, 보안을 할 수 있을 것이라 생각한다.

현재도 데이터에 대한 식별분류하는 솔루션들은 많이 있다. 다만 몇 가지 한계점을 가지고 있다. 현재의 솔루션은 식별분류만을 한다는 데에 한계점이 있다. 식별분류를 한 후에 이를 기반으로 중요데이터로써 보안과 관리를 해야 하는데 이에 필요한 정보를 충분히 다른 솔루션과 연계해서 전달되지 못하는 것이다. 즉 후속연동이 부족해 크게 활용할 수 없다는 부분이다.

불필요한 데이터를 지우는 것도 현재 가능하다.

해시값을 비교해서 100% 같은 파일은 중복제거가 가능하다. 하지만 스페이스 하나만 추가되어도 값이 달라지는 해시값 기반의 솔루션은 99% 같은 거의 비슷한 파일을 찾을 수 없다.

또한 불필요한 파일은 지우면 된다. 예를 들어서 회사에 10년된 파일 서버 안에 보면 지워야 하는 파일이 수도 없이 많다. 하지만 지울 수 있을까.

누구한테 물어 봐야 하나. 현재 정말로 사용하지 않는지. 어떤 것이 옛날 파일이고 현재 최신 버전의 파일은 어떤 것인지. 혹은 누가 보관해 놓기 위해서 올려 놓은 것은 아닌지.

이러한 이유로 지워야 되는 것은 알지만 지우지 못한 채 10년 이상을 운영하고 있게 된다.

불필요한 데이터를 줄이거나 관리하기 위해서는 아래의 6가지 메타정보가 필요하다.

1) Content ID : 콘텐트를 식별하는 고유번호

2) 사용내역 : 생성 시점부터 현재까지의 사용내역

3) 위치 : 파일의 물리적 저장 위치

4) 소유자 : 문서의 관리자 혹은 생성자에 대한 정보

5) 버전 : 최신 버전과 과거 버전에 대한 히스토리

6) 예외 : 커스텀 정보를 기록 관리

이러한 부분이 있어야 데이터에 대한 효율적 관리가 가능해지기 시작한다.

6가지 메타정보가 새롭게 등장한 것은 아니다. 기존의 솔루션들이 사용해왔고 아직도 활용되고 있는 부분이다.

다만 각각의 솔루션이 필요한 메타정보만을 관리 했기에 문제가 있는 것이다. DRM 솔루션은 'Content ID'와 '사용내역'에 대해서 관리하고 있다. 식별분류 솔루션들은 '위치'에 대한 메타정보를 사용하고 있다. ECM은 '소유자', '버전'에 대한 메타정보를 사용한다. 이렇듯 부분적인 메타정보를 각각의 솔루션이 관리하고 이를 서로 공유하지 않기에 데이터 보안과 관리가 쉽지 않은 것이다. 6개의 메타정보를 통합하고 데이터를 관리하게 되면 수많은 중복문서와 파생문서를 쉽게 관리해 데이터에 대한 효율적 관리가 시작 될 수 있다.

처음 예를 들었던 사업계획서 찾기를 다시 한 번 이용하겠다. 다만 이번에는 이러한 3가지 기반 기술이 적용 된 후다.

통합검색에 똑같이 2019년 사업계획서라는 키워드를 넣게 되면 이제는 단 하나의 검색 결과가 보여 질 것이다. 물론 하나의 보안정책이 적용된 채다.

내부적으로는 여러 개의 파생문서와 하위 버전이 있을 수 있다. 그리고 물리적 위치도 여러 군데 있을 수 있다. 다만 꼭 필요한 저장일 것이고 파생된 문서들도 거의 비슷한 내용의 문서일 것이 분명하다. 이제 우리는 원하는 정보를 쉽게 찾을 수 있고 적절한 보안정책에 따라 사용할 수 있게 되었다.

성공적인 데이터 보안과 관리는 현재의 데이터를 그대로 놓고 보안과 관리를 적용하는 것이 아니다. 모르는 데이터는 찾아서 식별분류하고 불필요한 데이터는 최소화해야 한다. 그리고 난 후에 적절한 보안을 적용하는 것이 매년 증가하는 운용 비용을 줄이고 새로운 기술을 적용 할 수 있을 것이다.

파수닷컴 김규봉 본부장의 PASCON 2019 발표자료는 데일리시큐 자료실에서 다운로드 가능하다.

파수닷컴은 최신 IT 트렌드 변화에 맞춰 혁신적인 솔루션과 서비스를 제공하며 국내는 물론 글로벌 시장에서의 입지를 넓혀가고 있는 소프트웨어 기업이다. 세계 최초로 DRM(Digital Rights Management) 기술을 상용화하고 국내 시장에서는 데이터 보안 1위 업체로서 안정적으로 성장하고 있으며, 해외 시장에서는 금융기관, 글로벌 제조업체, 국제기구, 정부기관, 글로벌 프렌차이즈 등 의미 있는 레퍼런스들을 확보하며 입지를 확실하게 다져나가고 있다.

또 DRM 시장을 넘어 중요 정보를 식별하고 분류하여 중요도에 따라 보안을 적용하고, 시용자 행동 분석을 통해 실시간으로 위협을 감지할 수 있도록 하는 데이터 보안 프레임워크를 제공하고 있다. 이와 함께 문서 보안 및 관리 솔루션, 외부 협업 솔루션, 빅데이터 비식별화 솔루션, 블록체인 기반의 진본증명 플랫폼, 인공지능 메모앱 서비스 등을 통해 관련 시장을 이끌어 나가고 있다. 이 밖에 애플리케이션 보안 솔루션인 Sparrow (스패로우)는 자회사로 독립하여 인공지능 기반의 차별화된 기능 제공과 우수한 성능으로 애플리케이션 보안 및 품질 테스팅 시장을 선도하고 있다.

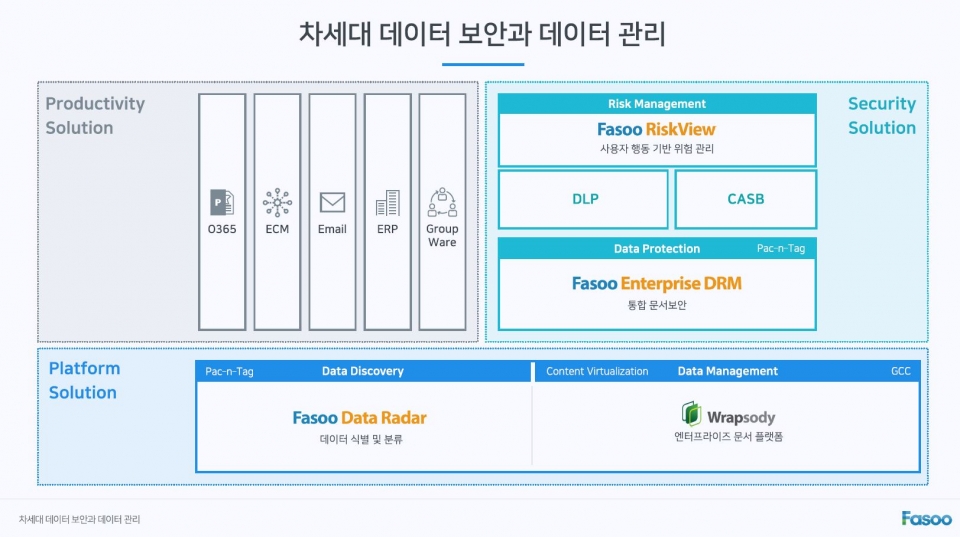

파수닷컨은 이번 PASCON 2019에 참가해 자사 솔루션을 소개했다. 강력한 데이터 보안 솔루션인 ‘Fasoo Enterprise DRM(파수 엔터프라이즈 디알엠)’과 중요 정보를 식별하고 분류하여 중요도에 따라 보안을 적용하는 데이터 식별 및 분류 솔루션인 ‘Fasoo Data Radar(파수 데이터 레이더)’, 조직 내 문서 사용자의 로그 데이터를 학습해 실시간으로 이상 패턴을 감지하여 사전에 위험요소를 능동적으로 대응할 수 있는 사용자 행동 기반 위험 관리 솔루션인 ‘Fasoo Risk View(파수 리스크 뷰)’가 긴밀하게 연관되는 다중 레이어 방식의 Fasoo Data Security Framework(파수 데이터 시큐리티 프레임워크)를 소개했다.

이와 함께, 콘텐츠 관리 플랫폼인 ‘랩소디(Wrapsody)’도 소개했다. 랩소디는 문서 가상화 기술을 기반으로 문서 위치에 관계 없이 항상 최신으로 자동 업데이트하며, 사용 이력, 연관 관계, 유통 경로 등을 파악할 수 있다. 또한 ECM, EDMS, ERP, 그룹웨어 등 각기 다른 시스템에 여러 버전으로 파편화되어 있는 문서들을 혁신적으로 통합 관리할 수 있다. 이를 통해 데이터 사일로(Silo) 현상을 해결하고, 중복되거나(Redundant) 오래되었거나(Obsolete) 불필요한(Trivial) 데이터를 일컫는 ROT 데이터를 포함한 모든 문서들을 효율적으로 관리할 수 있다. 특히, 문서 중심의 권한 통제 및 감사 로그 기능으로 보안성을 향상시키고 중요 문서는 권한 보유자만 확인할 수 있어 보다 안전한 문서 관리 환경 구축이 가능하다.

최근 전 세계적으로 데이터들이 어디에 있고 어떻게 관리되고 있는지를 파악하는 것이 보안의 핵심이 되고 있다. 파수닷컴은 계속해서 늘어나는 비정형 데이터들을 실시간으로 파악 및 자동 분류하고, 중요도에 따른 권한 통제, 사용 용도 등을 추적해 다양하고 유연한 보안 정책을 적용할 수 있도록 하는 ‘파수 데이터 레이더’를 국내외에 적극적으로 홍보 및 영업할 계획이다. 이와 함께, 차세대 문서관리/가상화 플랫폼인 ‘랩소디’도 더욱 활발하게 소개할 예정이다.

★정보보안 대표 미디어 데일리시큐!★